Seguramente has visto que en las últimas semanas grandes medios como la BBC y la propia comunidad SEO se hacían eco de una nueva actualización por parte de Google el 24 de octubre, llamada BERT (Bidirectional Encoder Representations from Transformers).

En el Departamento de SEO de Premium Leads hemos leído el artículo emitido por Google sobre la actualización para explicaros en detalle qué es BERT y cómo funciona.

Una introducción a BERT, la última actualización de Google

El propio Pandu Nayak, vicepresidente del Departamento de Búsqueda de Google relataba lo que suponía la incorporación de BERT para mejorar la respuesta a las búsquedas de los usuarios. En este comunicado hace hincapié en el trabajo que conlleva para ellos mostrar la información más adecuada en función de lo que busca una persona en Google.

Hay que tener en cuenta que lo más normal es que las personas combinen o eliminen determinadas palabras al escribir en el buscador, eliminando por completo la naturalidad. Por tanto, Google ha optado por implementar un sistema que mejore la compresión de lo que realmente busca el usuario.

Aunque los avances en comprensión son altos, BERT mejora por completo la forma con la que el buscador entiende al usuario. Conocer a la perfección lo que buscan los usuarios y mostrar la información más adecuada ha sido desde hace años uno de los mayores objetivos para Google.

¿Qué es BERT?

BERT es una técnica basada en redes neuronales utilizada en modelos de entrenamiento para la representación del lenguaje. En su origen, está basado en enmascarar de forma aleatoria determinados elementos de una frase o texto con el objetivo de predecir qué son. Este entrenamiento está basado en el llamada procedimiento de cloze, donde se omiten determinadas palabras de un texto y la persona que lo lee tiene que descubrir cuáles son dichas palabras.

Hay que tener en cuenta que es un modelo que ha sido entrenado con un corpus de más de 3.300 millones de palabras, procedentes de Wikipedia y del “BookCorpus”, un corpus muy popular utilizado en este tipo de modelos, pero que ya no se distribuye.

¿Cómo funciona BERT?

Para explicar cómo funciona el procesamiento del lenguaje por parte de BERT, creo que lo más fácil es recurrir a la propia explicación de Pandu Nayak en el comunicado de Google. Se refiere al funcionamiento de Bert como “un modelo que procesa palabras en relación con todas las otras palabras en una oración, en lugar de una por una en orden”. Este tipo de comprensión permite tener en cuenta el contexto completo de una palabra en función de las que están a su alrededor. Te lo explicamos con detalle más abajo.

Como seguramente habrás deducido, esto permite al buscador entender de forma correcta la intención del usuario, eliminando la ambigüedad que se producía hasta ahora en determinadas búsquedas.

¿Por qué Google apuesta por BERT? La importancia del contexto en la intención de los usuarios

Cuando hablamos de BERT, hablamos de PNL o Procesamiento del Lenguaje Natural. Esto puede sonar raro, pero este tipo de modelos de comprensión del lenguaje se llevan utilizando desde hace años para conseguir mecanismos que mejoren (el conocimiento por parte de las máquinas del lenguaje humano) la comunicación entre nosotros y las máquinas.

Estos modelos son entrenados a partir de grandes cantidades de datos con el objetivo de predecir relaciones entre las palabras o frases que se analizan. Además de predecir relaciones entre palabras, son capaces de reconocer entidades o responder a determinadas preguntas.

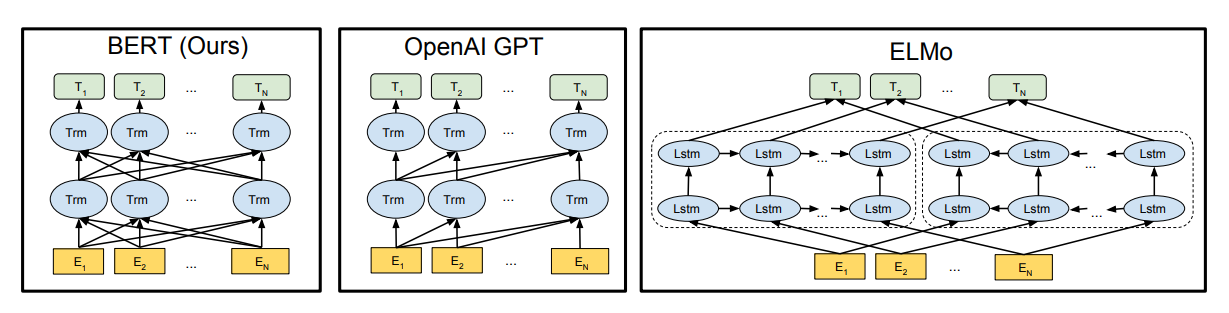

Digamos que, hasta ahora, los modelos existentes (ELMo o OpenAI) no eran capaces de mejorar la comprensión del lenguaje al nivel que lo consigue BERT. Estos modelos se basaban en lo que podríamos denominar un análisis unidireccional, que provocaba una limitación en sus entrenamientos y arquitectura. Otros como Word2vec tampoco logran un análisis de relación tan específico, interpretando palabra por palabra, en vez de su contexto. En cambio, se podría decir que BERT es mucho más contextual y bidireccional, como su propio nombre indica.

Por ejemplo:

“I made a bank deposit”

En este ejemplo buscamos la contextualización de la palabra “bank”.

Los modelos anteriores a BERT se basaban solo en la parte izquierda o derecha de la palabra: priorizaban “I made” pero no “deposit”, y viceversa. Con Bert, se basa en ambos lados, tanto en “I made” como en “deposit”, de forma que su funcionamiento es totalmente bidireccional. De esta forma, también se mejora la comprensión de determinadas palabras como “banco” que puede tener varios significados. Se entiende mucho mejor con la imagen de abajo, donde se deja claro que la interpretación es mucho más sofisticada.

Por otro lado, el vicepresidente de Búsqueda de Google expone la gran ventaja que incluye BERT en la clasificación de resultados, comprendiendo mejor 1 de cada 10 búsquedas. Hasta ahora, solo funciona en Estados Unidos, pero muchos SEOs ya se plantean si puede estar funcionando en Europa.

La mayor influencia de esta actualización se verá reflejada en long-tail o búsquedas que incluyan preposiciones como “para”, “entre”, “por”, etc. Gracias a esta técnica se podrá comprender mucho mejor el contexto que rodea a las palabras en el total de la frase, consiguiendo que el usuario realice una búsqueda mucho más natural. Además, también afecta a los featured snippets o fragmentos destacados, donde empezará a tener muy en cuenta este tipo de relaciones para mejorar sus resultados.

Veamos algún ejemplo en detalle:

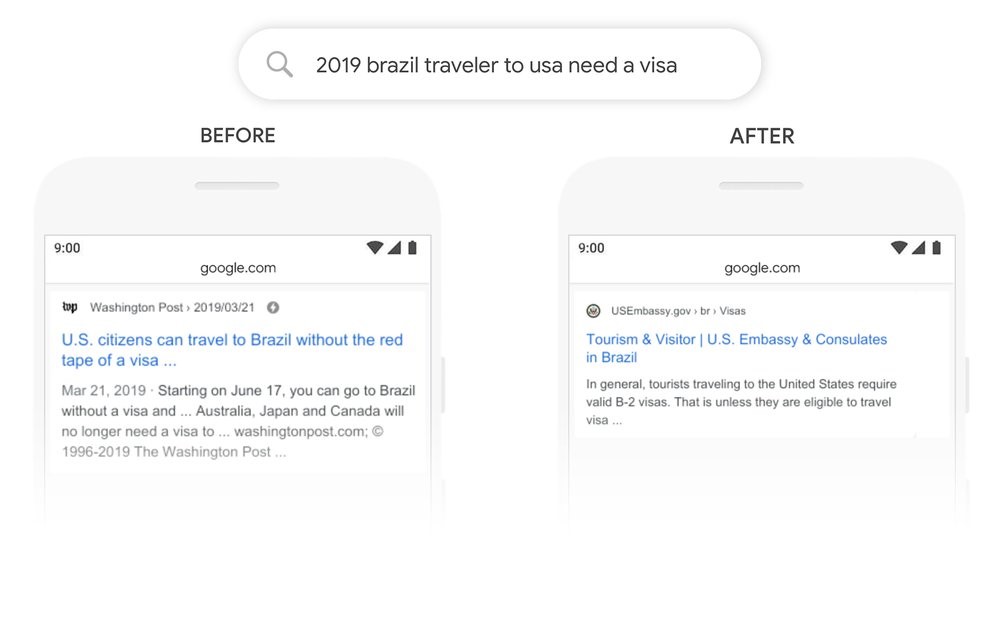

Creo que este ejemplo presentado por Pandu Nayak es uno de los mejores para entender el funcionamiento de este sistema, donde se tiene muy en cuenta el uso de las preposiciones y su posición en el texto para entender de forma correcta la búsqueda.

“2019 turista brasileño a estados unidos necesita una visa”

Como presenta Pandu en el comunicado, las palabras y preposiciones que unen esta frase son realmente importantes para entender el significado correcto de la búsqueda. La palabra “a” es vital para saber que el usuario está buscando sobre viajar a Estados Unidos, y no al revés. Hasta ahora, el algoritmo no era capaz de entender esta unión y ofrecía resultados de viajeros estadounidenses hacia Brasil. Con Bert esto no pasa y en este momento los resultados para esta búsqueda son muy distintos a los que eran antes de la actualización.

Igualmente, si encuentras algún resultado donde esto no funciona, recuerda que BERT se implementa en 1 de cada 10 búsquedas.

La influencia de Bert en el SEO: ¿cómo afecta esta actualización de Google a las SERPs?

El ecosistema de Google se encuentra en un periodo de constantes actualizaciones y los cambios en las SERPs son más regulares que nunca. Muchos SEOs echan de menos aquellos tiempos donde solo había una o dos actualizaciones del algoritmo al año.

Actualmente, la escena es distinta. En este año 2019 llevamos al menos 8 actualizaciones centrales del algoritmo, algunas no han sido ni confirmadas por el propio Google. Mejor no hablar de 2018, donde las herramientas que miden el histórico de actualizaciones señalan al menos 14 actualizaciones confirmadas.

Volvamos al tema principal: ¿cómo afecta BERT al SEO?

El 24 de octubre BERT empezó a funcionar dentro del algoritmo de Google. Desde ese día han aparecido numerosos debates en redes sobre su influencia con opiniones muy distintas. Este tema queda muy claro en el propio artículo emitido por Google sobre la actualización.

BERT afecta en la interpretación de las queries introducidas por el usuario en el buscador, no al contenido de una web. Esto no quiere decir que por nuestra parte no haya nada que hacer. Al contrario, vemos cómo Google premia cada vez más la naturalidad y, por tanto, como SEOs debemos dar mayor naturalidad a las webs y sobre todo al contenido. Quedan atrás las páginas optimizadas repitiendo la misma palabra clave una y otra vez a lo largo del texto, sobre todo la utilización de combinaciones extrañas y sin preposiciones.

¿Están relacionados Bert y la actualización de Google del 8 de noviembre?

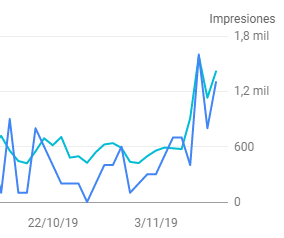

El viernes 8 de noviembre se comentó en la comunidad SEO la posibilidad de una nueva actualización en el algoritmo, no confirmada por parte de Google.

¿Puede ser que haya habido otro update ayer? #SEO pic.twitter.com/p1ai91xkRK

— Ālvaro Peña (@isocialwebseo) November 8, 2019

Yes, definitely some chatter about volatility starting around 11/7. I started reviewing sites & noticed some surges starting right on 11/7… Here are some screenshots of search visibility jumping. I see this in GA as well BTW. Could also be seasonal as the holidays kick in… pic.twitter.com/p7cDpypRbK

— Glenn Gabe (@glenngabe) November 9, 2019

En Premium Leads también hemos detectado bastantes cambios en algunas webs que no estaban yendo bien desde las últimas actualizaciones. Os dejamos algunos ejemplos:

Por nuestra parte, recomendamos mejorar la semántica del contenido añadiendo todo tipo de variaciones posibles que pueda utilizar un usuario cuando realiza una búsqueda. Sobre todo, no debemos olvidarnos de la naturalidad y siempre pensar en cómo lo haría un usuario, no un profesional del SEO.

¿Has detectado cambios en las SERPS durante el mes de noviembre? ¿Cómo crees que afectará Bert a tus proyectos y a la búsqueda de los usuarios? ¡Comparte tu experiencia con nosotros en los comentarios!