Explicamos los factores que debemos tener en cuenta para detectar cuándo parar un test A/B y saber si podemos extraer una conclusión a partir de los datos.

¿Por qué implementar un test A/B?

Tras un conversion research exhaustivo, hemos detectado un problema de conversión en nuestra web. En una reunión con todos los responsables implicados, surgen varias alternativas para solucionar el problema. Para confirmar cuál es la mejor solución, contrastamos las diferentes hipótesis a través de un test A/B (/n…). Pero tras varios días con el test en marcha, nos surge la duda… ¿podemos afirmar que alguna de las alternativas funciona mejor que las demás?

¿Cuándo parar un test A/B?

Es importante que no paremos un test demasiado pronto, pues podríamos tomar una decisión errónea con un falso positivo. Por otra parte, tampoco es cuestión de dejar el test funcionando durante excesivo tiempo. Si tenemos resultados concluyentes y positivos, apliquémoslos en nuestra web. Si no los tenemos, probemos un enfoque diferente. Que ninguna alternativa del test haya conseguido desmarcarse, no quiere decir que no hayamos aprendido nada.

¿Qué factores debemos tener en cuenta?

Hay tres requisitos indispensables que se deben cumplir antes de decidir parar un test:

1. Dos ciclos de negocio. El test debe estar en marcha durante, como mínimo, dos ciclos de negocio, que serán dos semanas, dos meses… en función de la estacionalidad de nuestro sector.

2. Confianza estadística. Podemos entender el concepto de confianza estadística como la probabilidad que tenemos de estar tomando una decisión acertada. Por tanto, nuestro objetivo será maximizar esta confianza estadística. El test nos proporcionará un resultado más certero cuanto mayor sea el nivel de confianza estadística (95% es un buen nivel), o lo que es lo mismo, cuanto menor sea la significancia estadística (5% es lo deseado). Lo habitual es que nuestra herramienta de testing nos proporcione este dato.

3. Tamaño de la muestra. No podemos considerar el test válido si no tenemos una cantidad de visitas mínima en cada una de las alternativas de nuestro test. Pero, ¿cuántas visitas? ¿cuál es el tamaño de la muestra mínimo?

¿Cuántas visitas son necesarias para considerar válido un test?

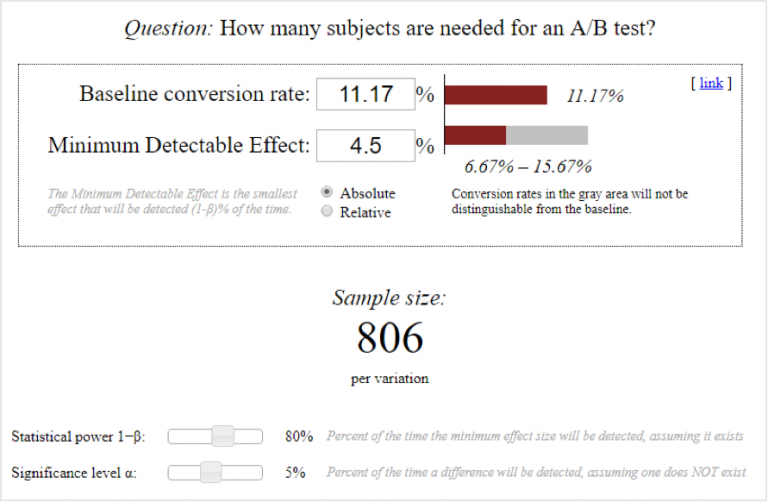

Para facilitar este cálculo, existen calculadoras online para test A/B donde, a partir de tres valores, obtenemos el tamaño mínimo de la muestra que debemos tener en cada una de las alternativas de nuestro test, es decir, el volumen de visitas que necesitamos en cada una de las alternativas de nuestro test para poder considerarlo concluyente.

Los tres valores que debemos introducir son:

• Ratio de conversión original: El porcentaje de conversión del grupo de control, es decir, de la versión original sin cambios.

• Impacto en la conversión: La variación mínima que se desea obtener en la conversión (en términos absolutos o relativos).

• Significancia estadística: La probabilidad de rechazar nuestra hipótesis cuando ésta es cierta. Como comentábamos, el nivel de significancia estadística ideal sería igual o menor al 5%.

Ejemplo práctico de cuándo parar un test A/B

En una página de producto, diseñada pensando en desktop, detectamos que en la versión móvil el usuario tenía que hacer scroll varias veces para llegar al botón a través del cual podía abrir un formulario de contacto. Dado que el objetivo de esa página era lograr el contacto del usuario con la empresa, pensamos en dar más visibilidad a ese botón para aumentar la conversión.

Pero nos surgió la duda: ¿qué convertiría mejor? ¿Funcionará mejor situar el CTA más arriba? ¿O funcionaría mejor la versión original, en la que el usuario tiene la oportunidad de informarse antes de llegar al CTA? Sabíamos que la mejor opción para responder a la pregunta era a través de un test A/B, así que nos pusimos manos a la obra, y configuramos un test para contrastar nuestra hipótesis.

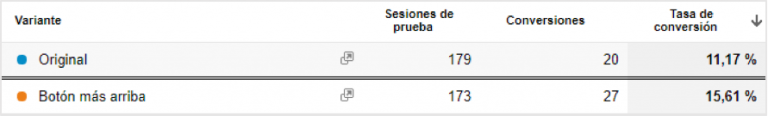

Tras varios días con el test en marcha vimos que la variante que habíamos creado parecía convertir mejor. Concretamente, la versión en la que se mostraba el botón de contacto más arriba parecía tener un impacto en la conversión de +4,5 puntos porcentuales.

Una vez pasados dos ciclos de negocio, y alcanzada una confianza estadística del 95%, ¿cuál sería el número mínimo de visitas que necesitaríamos para poder concluir que la variante tiene un impacto de +4,5 puntos porcentuales sobre la conversión? Introducimos los datos en la calculadora para estimar un número mínimo de usuarios:

Necesitaríamos 806 visitas, como mínimo, en cada una de las variantes de nuestro test para poder afirmar, con un 95% de confianza estadística, que situar el botón de contacto más arriba mejoraría la conversión de la página de producto en +4,5 puntos porcentuales. Es decir, aún debemos esperar unos cuantos días más para poder tomar una decisión en base a datos concluyentes.

Sin embargo, seguramente el impacto en conversión aún varíe tras ese tiempo, por lo que variará también el tamaño mínimo de la muestra. ¿Y si el impacto en conversión fuese menor?

Si el impacto en conversión fuese de +2,5 puntos porcentuales, necesitaríamos 2.562 visitas en cada una de las variantes de nuestro test para poder llegar a una conclusión. Es decir, el volumen de visitas necesario se multiplica según el impacto en conversión decrece.

Bonus track: ¿cómo puedo minimizar el tamaño mínimo de la muestra?

Si habéis introducido estos datos, y os habéis dado cuenta de que necesitáis mucho más tráfico del que pensabais para considerar concluyente el resultado de un test, debéis saber que hay dos maneras de minimizar el tamaño mínimo de la muestra:

• Con un impacto mayor en la conversión: Cuanto más drásticos sean los cambios introducidos a través del test A/B, mayor probabilidad habrá de impactar en la conversión. Para contrastar una gran variación en la conversión es necesario una muestra menor, mientras que para contrastar el impacto de un pequeño cambio (una palabra de todo un texto, por ejemplo) son necesarias muchas más visitas.

• Con una significancia estadística mayor (confianza estadística menor): Si queremos ser más precisos, necesitaremos más visitas para contrastar nuestra hipótesis, mientras que si nos conformamos con un nivel de precisión menor, podremos extraer conclusiones con un menor volumen de visitas.

Conclusión

A la hora de plantear tests deberemos tener en muy en cuenta el volumen de tráfico que tiene el site en cuestión, si lo que queremos es obtener un resultado concluyente en un periodo razonable de tiempo.